公開日: 2026年01月27日 / 更新日: 2026年01月27日

コラム

生成AIは本当に推論しているのだろうか

最近、ChatGPTが答えを出すまで、数十秒から数分かかることがある。

正直、少しだけイライラする。

最近、ChatGPTは少し難しい質問や専門的な質問をすると、自動的に推論モードに切り替わるようになった。

そのせいか回答の精度も上がった気がする。「チャッピー最高!」って感じる瞬間も、確実に増えている。

以前は「ChatGPT o3」など、推論モデルを自分で選ぶ必要があったが、

ChatGPT5になってからは質問内容に応じて自動で切り替わる。

モデル名の違いをいちいち気にするのが面倒だった私にとって、この仕様変更は素直にありがたい。

推論モードでは、しばらく考えてから答えが返ってくる。

その様子を見ていると、

「意外とちゃんと考えているじゃないか」

と感心することもある。

同時に、

「いや、これは本当に“考えている”と言っていいのだろうか」

と引っかかる瞬間もある。

突然まったく関係のないことを考え始めて、思わず笑ってしまうこともある。

むしろ、多少脱線させることで推論結果が良くなる、という人もいるくらいだ。

いずれにしても、推論モードで回答させたほうが精度が上がる、という実感はある。

ただ、ここで以前から気になっていることがある。

生成AIの推論と、人間の推論は、いったい何が違うのか。

生成AIは本当に「考えている」と言えるのだろうか。

もちろん、推論の定義次第では「推論している」と言うこともできるのかもしれない。

人は知性について考えるとき、どうしても自分たちを基準にしてしまう。

人間と同じようにできないとなると、「推論に限界がある」と言いたくなる。

でも、それよりも大事なのは人間の推論との違いだ。

生成AIの推論が本物かどうかよりも、

人間の推論とどう違うのか、そしてその違いが何を意味するのか。

それが、ずっと気になっている。

そんなことを考えながら、最近 Substack (英語版noteみたいなサービス)で生成AI関連の記事を読み漁っていたところ、ひとつ、とても興味深い記事に出会った。

予測はできるが、「なぜ」は安定しないAI

最近、発見してすごく面白かく読んだのが、ハーバード大学とマサチューセッツ工科大学の研究チームによる論文を紹介した、Substack の記事である。

正直に言えば、私はこの記事で引用されている論文を原文で読み通せるだけの専門知識を持っていない。

なので、ここから先は「この Substack の筆者の解釈をもとにすると……」という話になる。

この記事によれば、研究の要点はこうだ。

研究チームは、生成AIに惑星の軌道データを大量に学習させた。

その結果、惑星の位置の推移は、それなりに正確に予測されたという。

見た目だけを見れば、AIが物理法則を理解しているようにすら思えてくる。

しかし、条件を変えて同様の実験を行うと、印象は一変する。

軌道の予測そのものは保たれる一方で、それを生み出しているはずの「力」の構造を物理的に解釈しようとした時に、一貫した法則として再利用できる形が現れなかったのである。

同じ世界を説明しているはずなのに、データの条件が変わるたびに、説明のかたちが変わってしまう。

与えられたデータごとに、バラバラの定式化が行われたという。

つまりこの記事の筆者の解釈によれば、

物理法則を導き出すことができなかった

ということになる。

物理法則とは、本来、どこでも当てはまるルールのはずだからだ。

ニュートンの万有引力の法則自体は、生成AIが学習したデータのなかで何度も言及されている。

ある意味、生成AIはニュートンの法則を「知っていた」と言うこともできる。

それでも、そこに辿り着くことはなかった。

しかも、定式化(データを数式で解釈すること)に使われている数式は、人間には到底思いつかないほど複雑だったという。

人間の科学者は、データの背後にあるできるだけシンプルな法則を見出そうとする。

一方でAIは、与えられたデータを場当たり的に説明する方向に向かう性質があるらしい。

そもそも、私たちは何を「理解している」のか

ここで問題になっているのは、生成AIが「理解している」と言えるのかどうか、という点である。

ここでいう「理解」とは、単に答えを当てることではない。

要するに、

この世界は、どういう仕組みで動いているのか、という頭の中の捉え方

のことだ。

たとえば、誰かがコップに水を注ぎ、そのコップを倒したとしよう。

実際に床を見るまでもなく、多くの人は「水がこぼれただろう」と思う。

これは勘ではない。

水は液体で、容器から出れば重力に従って下に流れる。

そういう仕組みを、私たちは知っている。

そして、この知り方は特定の状況に限られない。

コップでも、ペットボトルでも、バケツでも、同じように当てはめることができる。

つまり、

一度つかんだ説明を、別の場面でもそのまま使える

という性質を持っている。

ここで問題になっているのは、まさにこの点だ。

ちなみに、ここまでの説明は、

先ほど紹介した Substack の記事をもとに、ChatGPT に説明してもらったものだ。

めちゃくちゃ分かりやすい。

「使い回せる理解」がないかもしれないのに(少なくとも、私が紹介した記事の筆者はそう考えている)、

これだけうまく説明できるのだから、もう何が何だか分からない。

こうした理解があると、何が違うのか

こうした「仕組みの捉え方」を持っていると、人は次のようなことができる。

・見たことのない状況でも、結果をある程度想像できる

・条件が少し変わっても、考え直して対応できる

・「なぜそうなるのか」を、自分の言葉で説明できる

つまり、

過去の経験を、そのまま別の状況に持ち運べる

という点が、大きな違いになる。

生成AIに、こうした理解が可能かどうかということが問題になっているということだ。

複雑な解釈がいいとは限らない

最近読んでいる『「予想外」を予想する』という本には複雑な定式化が必ずしもいい結果にならないことについて説明されている。

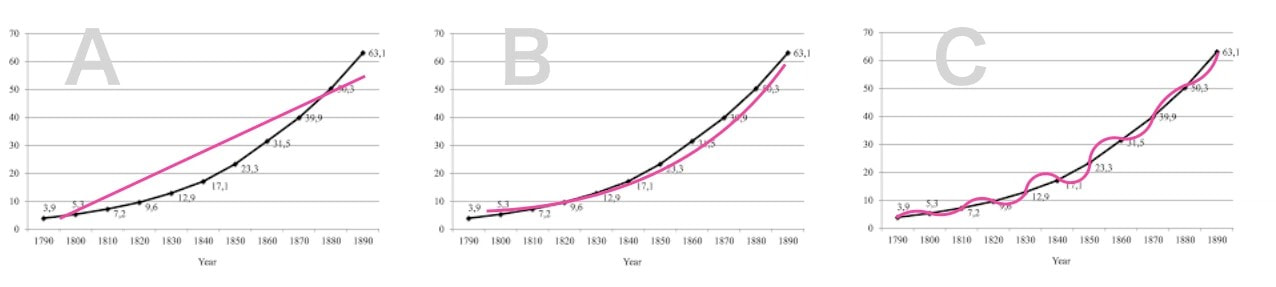

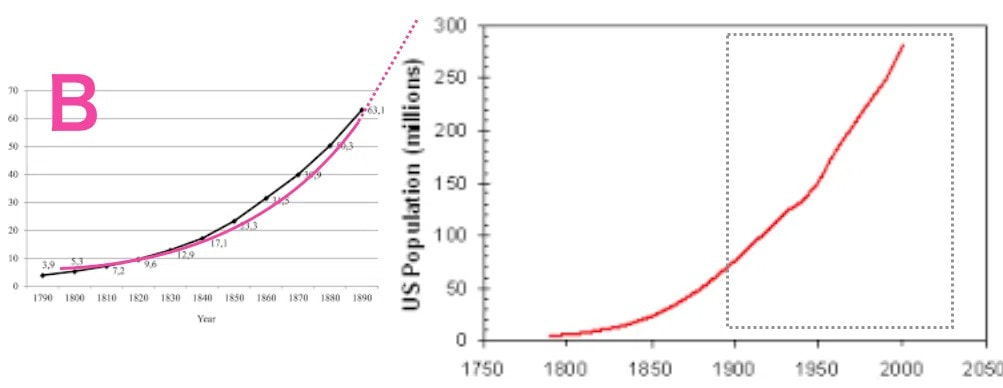

たとえば、1800年から1900年までの人口増加データを見て、将来を予測するとしよう。

考え方はいくつかある。

・単純に直線で延ばす

・成長の法則を仮定する

・データに極端に忠実な曲線を描く

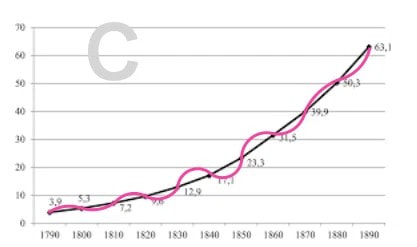

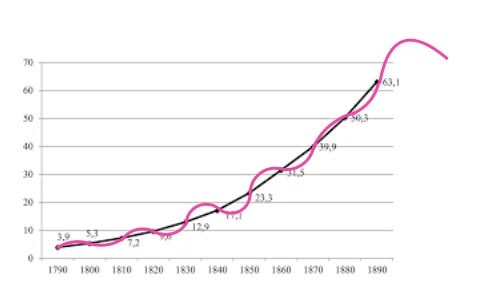

生成AIは、この中で「データにとても忠実な近似」を選びやすい。

つまり、上のグラフでいうと与えられたデータの点をかなり正確に通るけど、かなり複雑な式で表したがるということだ。

観測された範囲では、ピッタリなように見える。

しかし、そのまま外に延ばすと、急に意味を失う。

例えば上のような式で表すと、1900年以降は下の図のような変化をするかもしれない。

一方、人間はこのグラフを見て、そこから何らかの法則を見つけ出そうとする。

与えられたデータの範囲では誤差があっても、法則に基づいて考えることで、

1900年以降の人口増加についても、一定の見通しを立てようとする。

そうすることで、いい感じの予測が可能になる場合も多いのだ。

このように複雑な定式化がうまくいかないケースが多いということだ。

最初の物理法則の例では、生成AIが複雑な定式化をしてしまう傾向を示していると言える。

再利用できる理解

人間だって、軌道データを見ただけでニュートン力学に到達できるわけではない。

ただ、重要なのはここだ。

人間は一度獲得した説明を、別の現象に再利用できる

人は「力」という概念を理解すると、

惑星の運動も、

リンゴの落下も、

振り子の動きも、

同じ枠組みで考える。

今回紹介した研究や人口増加の例が示しているのは、

AIにはこの再利用される説明構造が、少なくとも現時点では

はっきりとは見られない、という点である。

ここに、人間の推論とAIの推論の決定的な違いがある、という話なのだ。

もっとも、この違いはすでに多くの研究者にも共有されており、「だからAIはここで行き止まりだ」と考えられているわけではない。

むしろ現在は、どうすればこのような再利用可能な説明をAIの内部に持たせることができるのか、という点そのものが、活発な研究テーマになっている。

おわりに

生成AIは、間違いなく強力な道具である。

多くの場面で、人間の仕事を助けてくれる。

ただしそれは、人間の思考をそのまま速くしたものではない。

得意なことの種類が、どうも違う。

AIは、パターンに忠実な予測を積み重ねるのがうまい。

人間は、意味を作り、説明を組み立て、それを別の場面に持ち運ぶのがうまい。

同じ「答え」に見えても、たどり着き方が違う。

この違いを意識せずにAIを使うと、私たちは「考えているつもり」で、実は考えないまま判断してしまうかもしれない。

便利さのぶんだけ、判断の責任が薄まっていく。

だからこれは、「AIが賢いかどうか」という話よりも、人間がどこで責任を引き受けるのかという話に近い。

……と言いつつ、私自身、その境界線をうまく引けている自信はあまりない。

助けられていると感じるほど、どこかで手放している気もする。

それでも、少なくとも一度立ち止まって、

「いま自分は考えているのか、それとも考えた“ことにしている”のか」

そう問い直す癖を持つようにしたいと考えさせられている。

書いた人:酒井 志郎

ITエンジニア。C++, VB, C#などを使ったプログラミングをシステム開発会社で10年間以上経験した後、

ロケットスタートに転職。kintoneのカスタマイズはじめロケスタのIT部分に幅広く携わる。